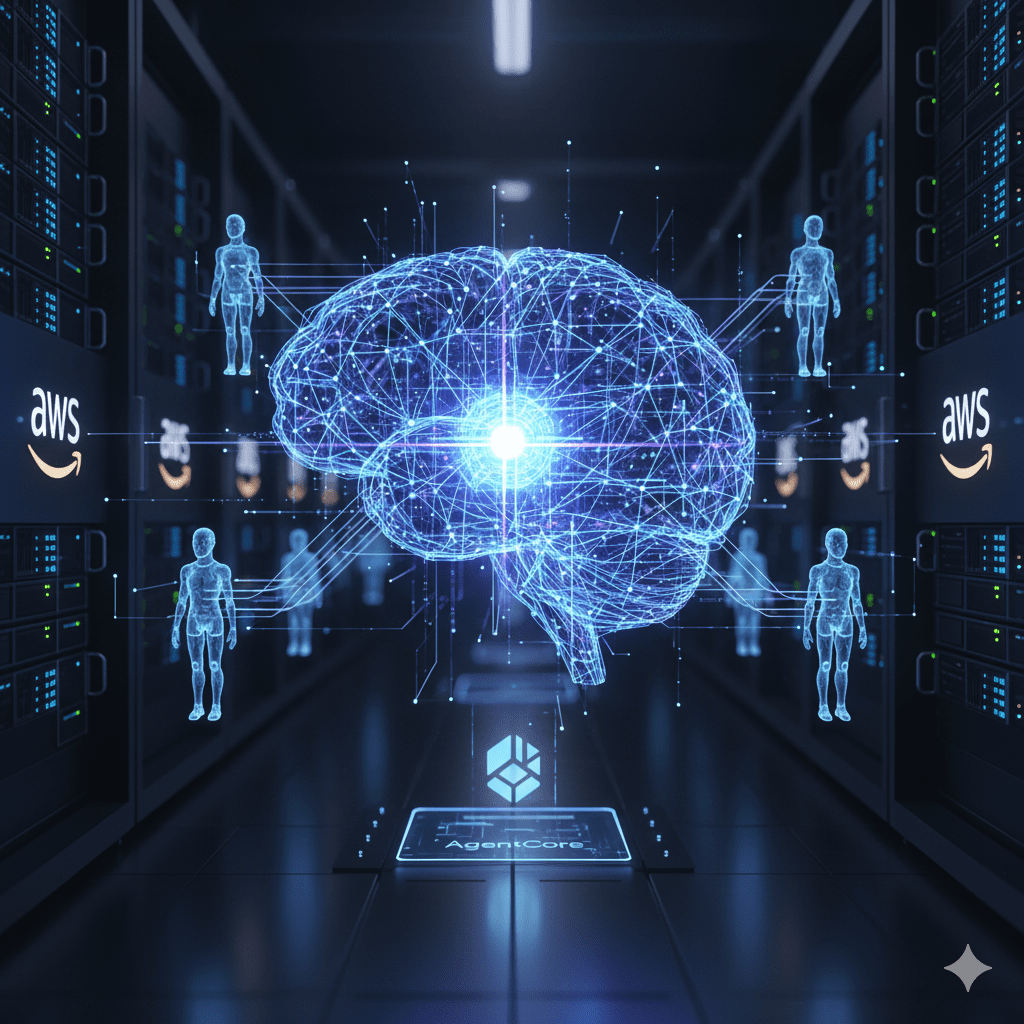

Amazon Bedrock Guardrails permite crear aplicaciones de IA generativa seguras y responsables mediante protecciones configurables que se aplican a múltiples modelos fundacionales. Estas barreras filtran contenido dañino en texto e imágenes, bloqueando hasta el 88% de material multimodal perjudicial, como odio, violencia o insultos.

Protecciones uniformes en todas las aplicaciones

Las Guardrails ofrecen un enfoque estándar para evaluar entradas y salidas del modelo, superando las protecciones nativas de los LLM. Incluyen filtros de temas prohibidos definidos en lenguaje natural, umbrales ajustables para contenido tóxico (ninguno, bajo, medio, alto) y detección de ataques como inyecciones de prompts.

Filtrado de contenido multimodal

Bloquean contenido dañino en texto e imágenes con precisión líder del sector. Ayudan a mitigar alucinaciones mediante razonamiento automatizado, que valida respuestas con hasta un 99% de precisión lógica y matemática, explicando por qué son correctas.

Protección de información confidencial

Detectan y enmascaran datos sensibles como PII (información personal identificable) en entradas y respuestas, usando expresiones regulares personalizadas. Esto asegura privacidad y cumplimiento normativo.

Para una empresa, implementar Bedrock Guardrails resuelve desafíos de gobernanza en IA, estandarizando seguridad en chatbots o asistentes, reduciendo riesgos legales y mejorando la confianza del usuario al desplegar aplicaciones a escala sin comprometer la innovación.

Fuente: AWS Machine Learning Blog