Los sonidos submarinos revelan patrones invisibles de especies marinas y su entorno. El océano rebosa de ruidos misteriosos, como el “biotwang” atribuido recientemente a ballenas de Bryde por la NOAA.

Google colabora en bioacústica para monitorear ballenas, desde modelos para jorobadas hasta uno multiespecie en 2024. En agosto de 2025, Google DeepMind lanzó Perch 2.0, un modelo fundacional entrenado principalmente en vocalizaciones de aves y animales terrestres, sin audio submarino.

Sorprendentemente, Perch 2.0 destaca en tareas marinas mediante transfer learning. Genera embeddings de audio que alimentan clasificadores simples, reduciendo cómputo para sonidos nuevos.

Evaluación en datasets como NOAA PIPAN (ballenas baleen), ReefSet (ruidos arrecife) y DCLDE (orcas por ecotipos) confirma su superioridad. Con pocos ejemplos por clase (4-32), logra alto AUC_ROC, superando modelos como SurfPerch o AVES.

Razones: modelos grandes generalizan bien; distingue cantos similares de aves (como tórtolas); similitudes en producción sonora entre aves y mamíferos marinos. Visualizaciones tSNE muestran clusters claros por clases.

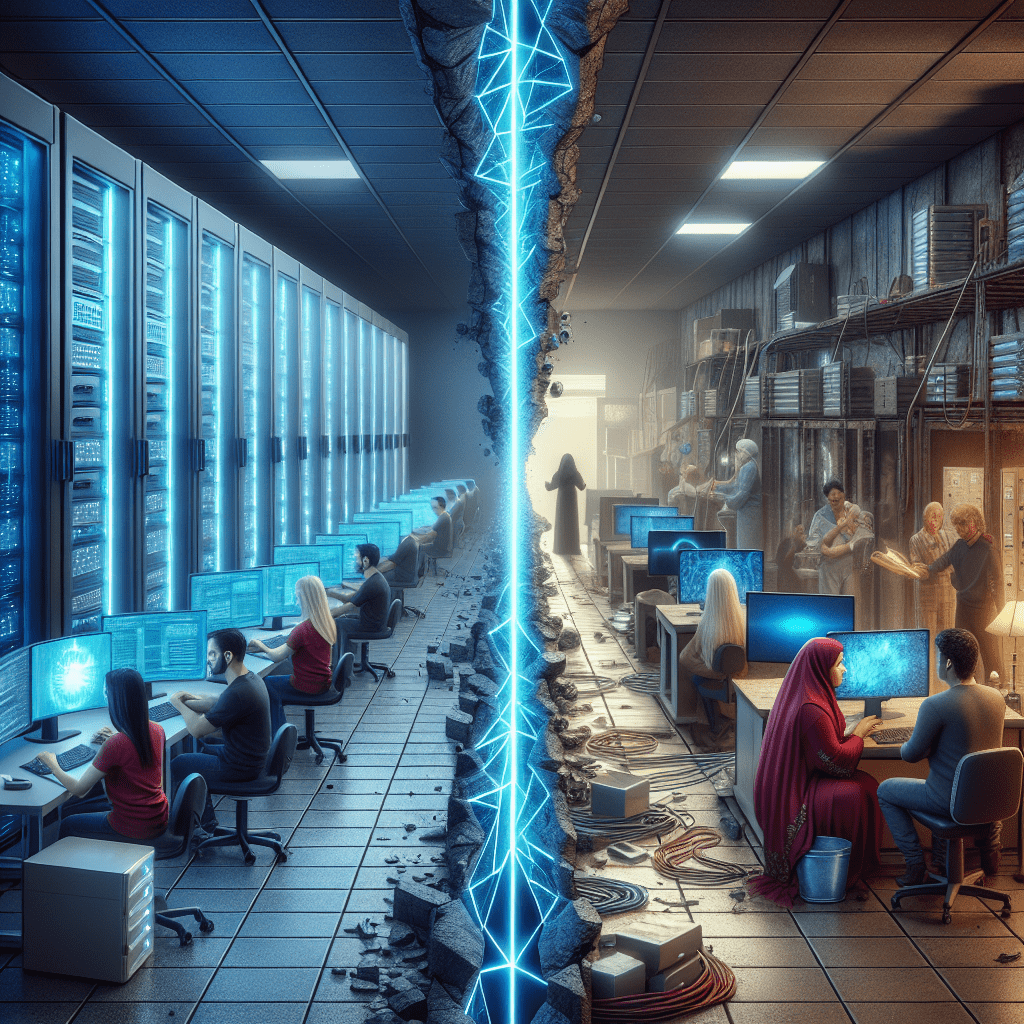

Esta noticia ofrece una solución para empresas de conservación o energías offshore: usen Perch 2.0 para clasificar sonidos marinos con pocos datos, escalando monitoreo de cetáceos y cumpliendo regulaciones ambientales de forma eficiente.

Fuente: Google Blog